機械学習の汎化能力考察|訓練誤差と汎化誤差の関係性

機械学習の汎化能力考察|訓練誤差と汎化誤差の関係性

更新日:2025年12月17日

1. 汎化能力の基本概念

1.1 汎化とは何か

機械学習における汎化(Generalization)とは、モデルが学習時に使用しなかったデータに対して適切に予測できる能力を指す。例えるなら、模擬試験で高得点を取った学生が本番の試験でも実力を発揮できるかどうか、という問題に相当する。模擬試験の問題を丸暗記しただけでは、異なる形式の問題には対応できない。同様に、機械学習モデルも訓練データの特徴を暗記するだけでなく、データの本質的なパターンを学習する必要がある。

1.2 訓練誤差と汎化誤差の定義

訓練誤差(Training Error)は、モデルの学習に使用したデータに対する予測誤差である。一方、汎化誤差(Generalization Error)は、モデルが未知のデータに対して示す予測誤差を指す。実務上、汎化誤差は直接測定できないため、検証データやテストデータに対する誤差で近似的に評価する。理想的なモデルは、訓練誤差と汎化誤差の両方が低い状態を実現する。

訓練誤差が低くても汎化誤差が高い場合、モデルは過学習(Overfitting)の状態にある。逆に、訓練誤差も汎化誤差も高い場合は、未学習(Underfitting)の状態である。両者のバランスを取ることが、実用的なモデル構築の鍵となる。

1.3 汎化能力が重要な理由

機械学習モデルの最終目的は、実世界の未知のデータに対して有用な予測を行うことである。訓練データに対する精度がいくら高くても、実際の運用で性能が発揮されなければ意味がない。医療診断、金融予測、自動運転など、あらゆる応用分野において汎化能力の確保は必須条件となる。汎化誤差を最小化することが、機械学習モデル構築における中心的な課題といえる。

2. 誤差の構造分析とトレードオフ

2.1 バイアス-バリアンス分解

汎化誤差は、バイアス(Bias)、バリアンス(Variance)、およびノイズ(Irreducible Error)の3つの成分に分解できる。この分解はBias-Variance Decompositionと呼ばれ、機械学習の理論的基盤を形成する重要な概念である。

| 成分 | 定義 | 原因 |

|---|---|---|

| バイアス | モデルの平均予測と真の値との差 | モデルの単純化・仮定の誤り |

| バリアンス | 訓練データの変動に対する予測のばらつき | モデルの過度な複雑さ |

| ノイズ | データ固有の削減不能な誤差 | 測定誤差・ランダム変動 |

バイアスが高いモデルは、データの本質的なパターンを捉えられない単純すぎるモデルである。線形モデルで非線形な関係を近似しようとする場合がこれに該当する。一方、バリアンスが高いモデルは、訓練データの細かな変動に過敏に反応し、ノイズまで学習してしまう複雑すぎるモデルである。

2.2 トレードオフの関係

バイアスとバリアンスはトレードオフの関係にある。モデルを単純にするとバイアスが増加しバリアンスが減少する。逆にモデルを複雑にするとバリアンスが増加しバイアスが減少する。汎化誤差を最小化するには、この両者のバランスが取れた「スイートスポット」を見つける必要がある。

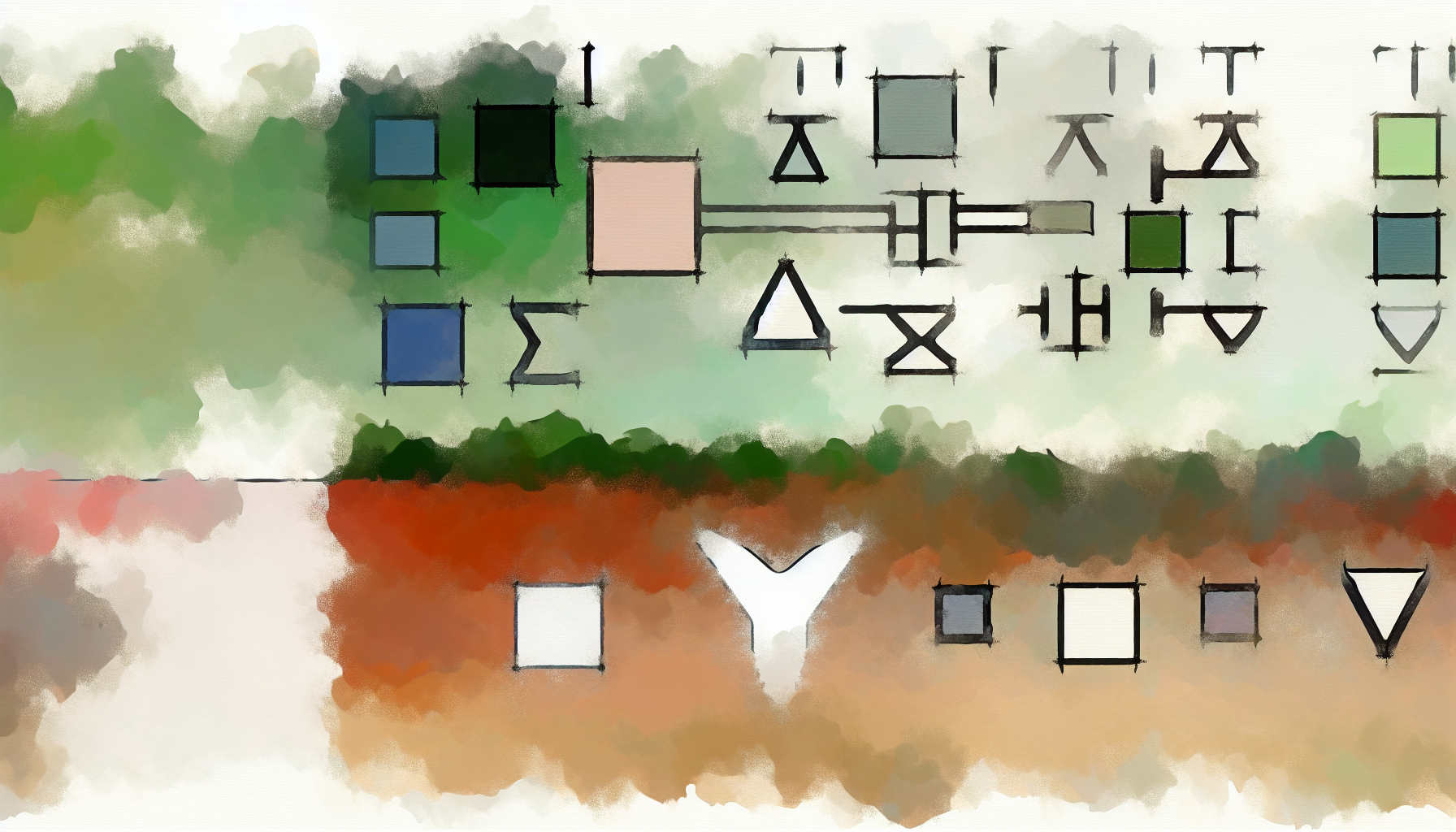

Fig. 1: モデル複雑度と誤差の関係(古典的U字カーブ)

2.3 Double Descent現象

近年の深層学習研究において、古典的なバイアス-バリアンストレードオフでは説明できない現象が報告されている。2019年にBelkinらが命名したDouble Descent現象である。従来の理論では、モデルの複雑度を上げすぎると汎化誤差が単調増加すると考えられていた。しかし、パラメータ数が訓練データ数を大きく超える過パラメータ化領域において、汎化誤差が再び減少することが観察された。

1989年:特定モデルでの類似現象の初期観察

2019年:Belkinらが「Double Descent」と命名、概念を一般化

2019年:OpenAIがCNN、ResNet、Transformerでの現象を報告

2024年:VC理論によるDouble Descentの理論的説明が進展

OpenAIの研究によれば、Double Descentはモデルサイズだけでなく、訓練エポック数に対しても観察される(Epoch-wise Double Descent)。また、訓練データにラベルノイズが含まれる場合に現象が顕著になることが報告されている。この現象は、過パラメータ化されたモデルが複数の補間解の中から「滑らかな」解を選択する帰納的バイアスによって説明されつつある。

Fig. 2: Double Descent現象の概念図

補間閾値(Interpolation Threshold)は、モデルのパラメータ数と訓練データ数が等しくなる点を指す。この閾値付近で汎化誤差のピークが現れることが多い。正則化や早期終了を適切に適用することで、このピークを回避できる場合がある。

3. 汎化能力を高める実践的手法

3.1 正則化手法

正則化(Regularization)は、モデルの複雑さにペナルティを課すことで過学習を防ぐ手法である。代表的な手法としてL1正則化(Lasso)とL2正則化(Ridge)がある。L1正則化は重みの絶対値の和にペナルティを課し、スパースな解を得やすい。L2正則化は重みの二乗和にペナルティを課し、重みを小さく保つ効果がある。ニューラルネットワークにおいては、ドロップアウト(Dropout)が広く用いられる。学習時にランダムにノードを無効化することで、特定のノードへの依存を防ぎ、汎化能力を向上させる。

3.2 交差検証

交差検証(Cross-Validation)は、データを複数の部分集合に分割し、各部分を順番に検証データとして使用する手法である。k分割交差検証では、データをk個に分割し、k回の学習と評価を行って平均性能を算出する。これにより、データの偏りに対してロバストな性能評価が可能となる。ハイパーパラメータの選択においても、交差検証による評価が推奨される。

Fig. 3: 汎化能力向上のための手法選択フロー

3.3 アンサンブル学習

アンサンブル学習は、複数のモデルの予測を組み合わせることで、単一モデルよりも高い汎化性能を実現する手法である。バギング(Bagging)は、ブートストラップサンプリングで生成した複数のデータセットでモデルを学習し、予測を平均化する。ランダムフォレストはこの代表例である。ブースティング(Boosting)は、前のモデルの誤りを修正するように逐次的にモデルを構築する。XGBoost、LightGBM、CatBoostなどの勾配ブースティング手法は、Kaggleなどの機械学習コンペティションで高い性能を示している。

汎化能力向上のためのチェックリスト

- データ品質の確認:ラベルノイズや欠損値の処理を適切に行う

- 適切なモデル複雑度の選択:交差検証で最適な複雑度を探索する

- 正則化の適用:L1/L2正則化やドロップアウトを検討する

- 早期終了の活用:検証誤差が上昇し始めた時点で学習を停止する

- データ拡張:画像認識などでは回転・反転などのデータ拡張が有効

3.4 まとめと考察

機械学習における汎化能力は、訓練誤差と汎化誤差の関係性を理解することで改善できる。古典的なバイアス-バリアンストレードオフは依然として有用な枠組みであるが、深層学習におけるDouble Descent現象は、過パラメータ化領域での新たな知見を提供している。実務においては、正則化、交差検証、アンサンブル学習などの手法を適切に組み合わせることが重要である。モデルの複雑度と汎化性能の関係は単純ではなく、データの特性やタスクに応じた検討が必要である。今後の研究により、Double Descent現象の理論的理解がさらに深まることが期待される。

本記事は2025年12月17日時点の情報に基づいて作成されています。記事内容は個人的な考察に基づくものであり、専門的な判断については機械学習の専門家や関連文献をご参照ください。技術の進展は予測困難であり、本記事の内容が将来的に修正される可能性もあります。重要な決定については、複数の情報源を参考にし、自己責任で行ってください。

他の記事を見る(30件)

- 中国のAI技術革新:オープンソースのエンドツーエンド自動運転システムApolloFM

- AI2027レポート考察2025|元OpenAI研究者が描く3年後の衝撃シナリオ

- AutoCAD AI操作考察2025|技術的現実と競合分析から見る完全自動化への道筋

- AutodeskニューラルCAD考察2025|AI設計革命で見えた40年ぶりCAD大転換

- 言語モデルと脳の乖離研究2025|CMUが解明した人間とAIの3つの決定的な違い

- AI時代に必要なスキル完全ガイド2025|生き残るための10の必須能力

- AIエージェント長時間稼働考察2025|GPT-5・Claude 4が示す数時間推論の新時代

- AI視覚的コンピュータ操作2025考察|18ヶ月で6倍性能向上の衝撃と未来展望

- Google研究:Nested Learning考察|壊滅的忘却を克服する新しい機械学習パラダイム

- China's AI Breakthrough: New Model Surpasses DeepSeek in Cost Efficiency

- China's AI Breakthrough: New Model Surpasses DeepSeek in Cost Efficiency

- NTT空間ノイズキャンセリング技術考察|イヤホン不要で室内全体を静音化する革新

- Google SIMA 2考察|Gemini統合による汎用AIエージェントの革新

- Sakana AI考察|自己改善するDarwin Gödel Machineが示すAI進化の新たな地平

- 【中学生向け】AIってなに?身近な例から学ぶ人工知能入門

- Google Antigravity発表考察|AI IDE競争の新局面とCursor・Windsurf比較

- Google Antigravity機能考察|エージェントファーストが変える開発体験

- AIベンチマーク完全ガイド2025|23種類の評価指標を徹底解説

- AIエージェントの自律性考察|従来型AIとの決定的な違いとは

- Claude「Soul Document」発見の考察|AIの人格設計という新領域

- 2026年AI動向考察|エージェント普及と学習データ枯渇が示す転換点

- Claude 4.5とGPT-5の推論能力比較考察|ベンチマークから見る実力差

- Agentic AI Foundation設立考察2025|AnthropicがMCPを寄贈しAIエージェント標準化へ

- AI時代のエンジニアに求められる基礎知識検討|統計学の重要性

- 機械学習の汎化能力考察|訓練誤差と汎化誤差の関係性

- マルチモーダルモデルの融合メカニズム分析|テキスト・画像統合学習の設計考察

- Transformer以後のアーキテクチャ動向検討|State Spaceモデルの可能性評価

- 注意機構の複雑性削減研究考察|線形注意メカニズムの実用性評価

- Claude MCP エコシステム分析|外部ツール統合による拡張性の考察

- GPT-5.2の技術的特性と市場動向に関する考察

PR:関連サービス

PR:関連サービス

コメント (0)

まだコメントはありません。